SEO क्लोकिंग क्या है? कारण, तरीके और समाधान

नीचे पुराने लेख से नए लेख में छवियों का स्थानांतरण किया गया है। पुराना लेख और नया लेख दोनों दिखाए गए हैं, जिसमें नए लेख में उचित स्थानों पर छवियाँ डाली गई हैं।

पुराना लेख (मूल)

SEO क्लोकिंग एक तकनीक है जिसमें वेबसाइट सामान्य उपयोगकर्ताओं को अलग सामग्री दिखाती है और सर्च इंजन को अलग।

यह एक ब्लैक हैट तकनीक है जिसका उपयोग सर्च इंजनों को धोखा देने के लिए किया जाता है। इसका उद्देश्य परिणाम पृष्ठ में उच्च रैंकिंग प्राप्त करना या उपयोगकर्ताओं को अवांछित पेज या वेबसाइटों पर रीडायरेक्ट करना होता है।

SEO क्लोकिंग क्या है?

जैसा कि हमने अभी बताया, यह एक ब्लैक हैट तकनीक है जिसे विज़िटर्स को एक प्रकार की सामग्री दिखाने और Googlebot तथा अन्य सर्च इंजन बॉट्स या स्पाइडर्स को दूसरी सामग्री दिखाने के लिए बनाया गया है। इसे क्लोकिंग कहा जाता है, और यह सर्च इंजन बॉट्स को यह सोचने के लिए धोखा देने की कोशिश है कि पेज में वह सामग्री है जो वास्तव में दिखाई जाती है उससे अलग है।

आजकल यह Google की गुणवत्ता दिशानिर्देशों का बड़ा उल्लंघन है। कोई भी साइट जो इसका उल्लंघन करती है, उसकी रैंकिंग गिराई जा सकती है या उसे पूरी तरह से इंडेक्स से हटा दिया जा सकता है।

क्लोकिंग का एक उदाहरण हो सकता है; एक संक्रमित वेबसाइट सामान्य उपयोगकर्ताओं को फ्लैश या वीडियो सामग्री दिखाती है, लेकिन सर्च इंजनों को टेक्स्ट दिखाती है। टेक्स्ट सामग्री होम रिमॉडलिंग के बारे में हो सकती है लेकिन वीडियो पोर्न दिखा सकता है।

बेशक, यह सर्च इंजनों के लिए एक बड़ी समस्या बन गया। उपयोगकर्ता भ्रमित और खराब अनुभव से असंतुष्ट थे। और जैसा कि हम जानते हैं कि Google चाहता है कि उपयोगकर्ता बार-बार आएं, इसलिए इसे ठीक करना आवश्यक था।

क्लोकिंग क्यों उपयोग किया जाता था?

मूल रूप से यह रैंकिंग में तेजी से सुधार पाने के लिए एक ब्लैक हैट SEO तकनीक थी। आजकल यह एक लोकप्रिय हैकर तकनीक है। जब हैकर्स किसी वेबसाइट में घुसपैठ करते हैं, तो वे आपके वेब पेजों में ऐसे लिंक और कोड इंजेक्ट कर सकते हैं जो केवल बॉट्स को दिखते हैं, सामान्य विज़िटर्स को नहीं। या वे उपयोगकर्ताओं को बिना वेबसाइट मालिक की जानकारी के दूसरी वेबसाइट पर रीडायरेक्ट कर सकते हैं, मूलतः वेबसाइट का ट्रैफ़िक चुरा लेते हैं। असली वेबसाइट मालिक जानबूझकर क्लोकिंग की अनुमति कभी नहीं देंगे क्योंकि अगर सर्च इंजन इसे पकड़ ले तो नुकसान बहुत बड़ा हो सकता है।

क्या क्लोकिंग कभी स्वीकार्य है?

उपयोगकर्ता के डेटा का उपयोग करके थोड़ी अलग जानकारी लौटाना पूरी तरह से वैध तकनीक है। उदाहरण के लिए, जियोलोकेशन के साथ, जब आप चाहते हैं कि अलग शहर, राज्य या देश के उपयोगकर्ताओं को आपकी साइट का अलग संस्करण दिखाया जाए। यह भाषा, मुद्रा, स्थानीय विज्ञापन आदि के लिए हो सकता है।

मोबाइल डिवाइस और डेस्कटॉप के लिए अलग-अलग पेज संस्करण देना भी सामान्य है। यह केवल तब असामान्य होता है जब सर्च इंजन और उपयोगकर्ता को अलग-अलग प्रकार की सामग्री दी जाती है। तब वेबसाइट को पेनल्टी मिल सकती है क्योंकि उद्देश्य सर्च इंजन और उपयोगकर्ता को धोखा देना होता है।

क्लोकिंग कैसे किया जाता है?

यूजर एजेंट वह सॉफ्टवेयर है जिसके द्वारा वेबसाइट एक्सेस की जाती है। आपका ब्राउज़र एक यूजर एजेंट है। लिनक्स सर्वरों पर अक्सर .htaccess फाइल को हाईजैक करके mod_rewrite मॉड्यूल में कोड डाला जाता है। यह मॉड्यूल सामान्य विज़िटर्स और सर्च इंजन बॉट्स को {HTTP_USER_AGENT} के UserAgentName एट्रिब्यूट से पहचान सकता है। फिर यह पेज की दो अलग-अलग सामग्री दिखाता है - एक आपके लिए और दूसरी पूरी तरह अलग सर्च इंजन बॉट्स के लिए। एक अन्य तरीका Googlebot के IP पते पर ध्यान केंद्रित करना है और जब इसे पहचाना जाए तो अलग सामग्री देना।

क्लोक्ड सामग्री देने के 6 सबसे सामान्य तरीके

क्लोकिंग के लिए प्रोग्रामिंग ज्ञान जरूरी होता है लेकिन ब्लैक हैट टूल्स और प्लगइन्स का भी उपयोग होता है। सबसे सामान्य तकनीकें हैं:

-

IP पता पहचान

हर यूजर एजेंट अनुरोध के साथ उपयोगकर्ता का IP पता वेब सर्वर को भेजा जाता है। सिस्टम इसे इंटरसेप्ट कर सकता है और उपयोगकर्ता अनुरोध को वेबसाइट के किसी भी पेज या दूसरी वेबसाइट पर रीडायरेक्ट कर सकता है।

-

यूजर-एजेंट इंटरसेप्शन

आपका ब्राउज़र यूजर एजेंट का एक उदाहरण है। स्पाइडर और क्रॉलर इसके अन्य उदाहरण हैं। मूल रूप से, यूजर एजेंट वे माध्यम हैं जो वेबसाइट से डेटा प्राप्त करते हैं। वेब सर्वर यूजर एजेंट की प्रकार पहचान कर सामग्री परोस सकते हैं।

-

जावास्क्रिप्ट क्षमता

उपयोगकर्ता ब्राउज़र आमतौर पर जावास्क्रिप्ट सक्षम होते हैं, जबकि सर्च इंजन क्रॉलर नहीं। इससे पता लगाना आसान हो जाता है कि JS सक्षम है या नहीं, और फिर सर्च इंजन बॉट्स को अलग पेज दिखाना।

-

HTTP Accept-language हेडर परीक्षण

यूजर अनुरोध का 'HTTP Accept-Language' एट्रिब्यूट सिस्टम को बताता है कि उपयोगकर्ता सर्च इंजन है। फिर क्लोकिंग लॉजिक अलग वेब पेज परोसता है।

-

HTTP_REFERER जांच

इसी तरह, 'HTTP_REFERER' हेडर एट्रिब्यूट से पता चलता है कि उपयोगकर्ता एजेंट सर्च इंजन क्रॉलर है। इससे अलग-अलग वेब पेज संस्करण परोसना संभव होता है।

-

टेक्स्ट या लिंक छुपाना

यह तकनीकी रूप से अन्य क्लोकिंग तकनीकों जैसा नहीं है, लेकिन यह सर्च इंजनों को धोखा देने का प्रयास है और इसे भी अवांछनीय माना जाता है।

उदाहरण:

- छवि के पीछे टेक्स्ट छुपाना।

- फॉन्ट साइज को शून्य करना।

- टेक्स्ट का रंग बैकग्राउंड के समान करना (जैसे सफेद टेक्स्ट सफेद पृष्ठभूमि पर)।

- CSS या अन्य गैर-तकनीकी तरीकों से टेक्स्ट को स्क्रीन से हटाना।

कैसे जांचें कि आपकी वेबसाइट SEO क्लोकिंग का उपयोग कर रही है?

क्योंकि हैकर्स वेबसाइट में घुसपैठ कर क्लोकिंग कोड स्थापित कर सकते हैं, आपको समय-समय पर अपनी वेबसाइट की जांच करनी चाहिए। यह वेबसाइट मालिकों के लिए एक बेहतरीन अभ्यास है।

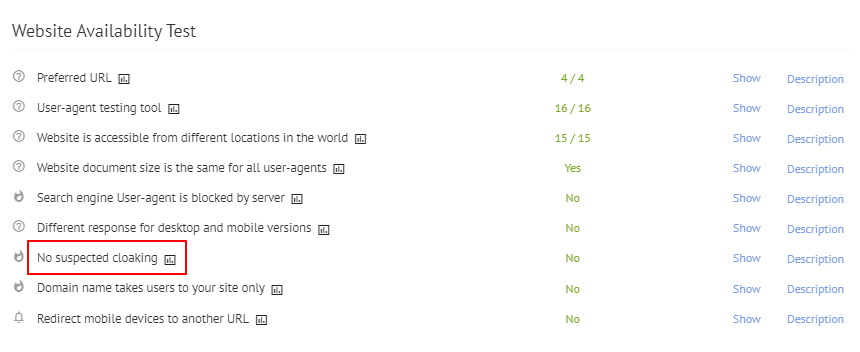

आप Labrika की वेबसाइट उपलब्धता जांच का उपयोग कर सकते हैं, जो तकनीकी साइट ऑडिट में मिलती है। यदि आपकी वेबसाइट में क्लोकिंग की समस्या हो तो इस ऑडिट में चेतावनी दिखाई देगी।

इसके अलावा, आप Google के URL इंस्पेक्शन टूल का उपयोग कर सकते हैं। यह आपको दिखाएगा कि Google आपके पेजों को कैसे देखता है, और आप पेज की सामग्री या कोड में आवश्यक सुधार कर सकते हैं। "website cloaking checker" खोजने पर कई मुफ्त टूल मिलेंगे जो तुरंत जांच कर सकते हैं। वैकल्पिक रूप से, पेशेवर वेबसाइट रखरखाव सेवाएं ये जांच सेवा पैकेज का हिस्सा के रूप में करती हैं, जिससे आपको शांति मिलती है। आप Google या Google Search Console से हैकिंग अलर्ट भी सेट कर सकते हैं।

SEO क्लोकिंग समस्याओं को कैसे ठीक करें

जब आपको पता चले कि आपकी वेबसाइट पर क्लोकिंग समस्या है, तो यह पेशेवर सहायता लेने का समय हो सकता है। इसे पहचानना और ठीक करना दोनों ही श्रमसाध्य और तकनीकी हो सकते हैं। इसे ठीक करने और भविष्य में समस्या न हो, यह सुनिश्चित करने के लिए विशेषज्ञ मदद जरूरी होती है। क्लोकिंग की समस्या को तुरंत ठीक करना चाहिए क्योंकि यह आपकी रैंकिंग और पैसे पर जल्दी प्रभाव डाल सकती है। आगे बढ़ते हुए क्लोकिंग जांचना आपकी वेबसाइट प्रबंधन की नियमित प्रक्रिया का हिस्सा होना चाहिए।

सुविधा और शांति के लिए, यह कार्य आप Labrika के तकनीकी साइट ऑडिट > वेबसाइट उपलब्धता जांच के माध्यम से कर सकते हैं।

नया लेख (छवियों के साथ समन्वित)

SEO क्लोकिंग एक तकनीक है जिसमें वेबसाइट सामान्य उपयोगकर्ताओं को अलग सामग्री दिखाती है और सर्च इंजन को अलग।

यह लेख search engine optimization और विशेष रूप से SEO क्लोकिंग पर केंद्रित एक व्यावहारिक guide है, जिसमें हम step-by-step यह समझते हैं कि search engines इस व्यवहार को कैसे detect करते हैं, इसका your website की ranking, traffic और user experience पर क्या प्रभाव होता है, और वेबसाइट मालिक इसे legal और सुरक्षित तरीके से कैसे रोक सकते हैं।

यह एक ब्लैक हैट तकनीक है जिसका उपयोग सर्च इंजनों को धोखा देने के लिए किया जाता है। इसका उद्देश्य परिणाम पृष्ठ में उच्च रैंकिंग प्राप्त करना या उपयोगकर्ताओं को अवांछित पेज या वेबसाइटों पर रीडायरेक्ट करना होता है।

व्यावहारिक रूप से यह ब्लैक हैट एसईओ तकनीक के रूप में जाना जाता है, क्योंकि यह search engine algorithms को manipulate कर के short term gains के लिए long term जोखिम पैदा करती है।

SEO क्लोकिंग क्या है?

जैसा कि हमने अभी बताया, यह एक ब्लैक हैट तकनीक है जिसे विज़िटर्स को एक प्रकार की सामग्री दिखाने और Googlebot तथा अन्य सर्च इंजन बॉट्स या स्पाइडर्स को दूसरी सामग्री दिखाने के लिए बनाया गया है। इसे क्लोकिंग कहा जाता है, और यह सर्च इंजन बॉट्स को यह सोचने के लिए धोखा देने की कोशिश है कि पेज में वह सामग्री है जो वास्तव में दिखाई जाती है उससे अलग है।

ऑन-पेज optimization के संदर्भ में यह समझना जरूरी है कि search engine bots जिस HTML, text, link structure, meta signals और internal navigation को crawl करते हैं, यदि वह users के सामने live version में अलग रूप में प्रदर्शित हो, तो search engines इसे deceptive pattern मानते हैं और साइट को manual action या algorithmic penalty दे सकते हैं।

आजकल यह Google की गुणवत्ता दिशानिर्देशों का बड़ा उल्लंघन है। कोई भी साइट जो इसका उल्लंघन करती है, उसकी रैंकिंग गिराई जा सकती है या उसे पूरी तरह से इंडेक्स से हटा दिया जा सकता है।

Google Search Console, Bing Webmaster Tools और अन्य search engine platforms अक्सर ऐसी sites के लिए warning, security issues या indexing problems दिखाते हैं, इसलिए site owners को नियमित रूप से इन reports को read कर के timely actions लेने चाहिए।

क्लोकिंग का एक उदाहरण हो सकता है; एक संक्रमित वेबसाइट सामान्य उपयोगकर्ताओं को फ्लैश या वीडियो सामग्री दिखाती है, लेकिन सर्च इंजनों को टेक्स्ट दिखाती है। टेक्स्ट सामग्री होम रिमॉडलिंग के बारे में हो सकती है लेकिन वीडियो पोर्न दिखा सकता है।

ऐसे misleading formats न केवल organic rankings को नुकसान पहुँचाते हैं, बल्कि business brand, lead generation funnel और overall digital marketing strategy पर भी नकारात्मक प्रभाव डालते हैं, क्योंकि users का trust कम हो जाता है और bounce rate बढ़ जाता है।

बेशक, यह सर्च इंजनों के लिए एक बड़ी समस्या बन गया। उपयोगकर्ता भ्रमित और खराब अनुभव से असंतुष्ट थे। और जैसा कि हम जानते हैं कि Google चाहता है कि उपयोगकर्ता बार-बार आएं, इसलिए इसे ठीक करना आवश्यक था।

इसी कारण ज्यादातर white hat practices, technical audits और quality-focused contents को बढ़ावा दिया गया, ताकि websites high quality जानकारी, fast page speed और साफ-सुथरे design के साथ users तथा crawlers दोनों के लिए consistent अनुभव प्रदान करें।

क्लोकिंग क्यों उपयोग किया जाता था?

मूल रूप से यह रैंकिंग में तेजी से सुधार पाने के लिए एक ब्लैक हैट SEO, यानी एसईओ तकनीक थी। आजकल यह एक लोकप्रिय हैकर तकनीक है। जब हैकर्स किसी वेबसाइट में घुसपैठ करते हैं, तो वे आपके वेब पेजों में ऐसे लिंक और कोड इंजेक्ट कर सकते हैं जो केवल बॉट्स को दिखते हैं, सामान्य विज़िटर्स को नहीं। या वे उपयोगकर्ताओं को बिना वेबसाइट मालिक की जानकारी के दूसरी वेबसाइट पर रीडायरेक्ट कर सकते हैं, मूलतः वेबसाइट का ट्रैफ़िक चुरा लेते हैं। असली वेबसाइट मालिक जानबूझकर क्लोकिंग की अनुमति कभी नहीं देंगे क्योंकि अगर सर्च इंजन इसे पकड़ ले तो नुकसान बहुत बड़ा हो सकता है।

कई मामलों में attackers off page seo signals को भी manipulate करने की कोशिश करते हैं, जैसे कि spam backlinks building, hacked blog networks और doorway pages, ताकि short term में serp पर higher position हासिल की जा सके; लेकिन जब यह pattern detect हो जाता है, तो पूरी domain authority और existing rankings गंभीर रूप से प्रभावित हो सकती हैं।

क्या क्लोकिंग कभी स्वीकार्य है?

उपयोगकर्ता के डेटा का उपयोग करके थोड़ी अलग जानकारी लौटाना पूरी तरह से वैध तकनीक है। उदाहरण के लिए, जियोलोकेशन के साथ, जब आप चाहते हैं कि अलग शहर, राज्य या देश के उपयोगकर्ताओं को आपकी साइट का अलग संस्करण दिखाया जाए। यह भाषा, मुद्रा, स्थानीय विज्ञापन आदि के लिए हो सकता है।

इसे सही तरीके से implement करने पर यह personalisation, local seo targeting और बेहतर user experience का हिस्सा माना जाता है, बशर्ते search engines को वही core contents, title, description और primary keywords दिखाई दें जो सामान्य users को दिखाई देती हैं।

मोबाइल डिवाइस और डेस्कटॉप के लिए अलग-अलग पेज संस्करण देना भी सामान्य है। यह केवल तब असामान्य होता है जब सर्च इंजन और उपयोगकर्ता को अलग-अलग प्रकार की सामग्री दी जाती है। तब वेबसाइट को पेनल्टी मिल सकती है क्योंकि उद्देश्य सर्च इंजन और उपयोगकर्ता को धोखा देना होता है।

Responsive design, dynamic serving या अलग मोबाइल URL structure का उपयोग करते समय भी यह सुनिश्चित करना महत्वपूर्ण है कि technical implementation स्पष्ट हो, hreflang और canonical tags सही हों और किसी भी तरह से एसईओ संकेतों में विरोधाभास न बने।

क्लोकिंग कैसे किया जाता है?

यूजर एजेंट वह सॉफ्टवेयर है जिसके द्वारा वेबसाइट एक्सेस की जाती है। आपका ब्राउज़र एक यूजर एजेंट है। लिनक्स सर्वरों पर अक्सर .htaccess फाइल को हाईजैक करके mod_rewrite मॉड्यूल में कोड डाला जाता है। यह मॉड्यूल सामान्य विज़िटर्स और सर्च इंजन बॉट्स को {HTTP_USER_AGENT} के UserAgentName एट्रिब्यूट से पहचान सकता है। फिर यह पेज की दो अलग-अलग सामग्री दिखाता है - एक आपके लिए और दूसरी पूरी तरह अलग सर्च इंजन बॉट्स के लिए। एक अन्य तरीका Googlebot के IP पते पर ध्यान केंद्रित करना है और जब इसे पहचाना जाए तो अलग सामग्री देना।

ऐसी server level configurations के अतिरिक्त, कुछ प्लगइन्स, scripts और third party services भी होते हैं जो cloaking logic को automate कर देते हैं; किसी भी professional agency या in-house technical team के लिए यह अनिवार्य है कि वे नियमित security audits, log analysis और code reviews के माध्यम से ऐसी suspicious entries को जल्द detect करें।

क्लोक्ड सामग्री देने के 6 सबसे सामान्य तरीके

क्लोकिंग के लिए प्रोग्रामिंग ज्ञान जरूरी होता है लेकिन ब्लैक हैट टूल्स और प्लगइन्स का भी उपयोग होता है। सबसे सामान्य तकनीकें हैं:

व्यवहार में यह अलग-अलग types seo हमलों, spam campaigns और automated scripts के रूप में दिखाई देता है, जिनका उद्देश्य search algorithms को confuse कर के short cuts से visibility बढ़ाना होता है।

IP पता पहचान

- हर यूजर एजेंट अनुरोध के साथ उपयोगकर्ता का IP पता वेब सर्वर को भेजा जाता है। सिस्टम इसे इंटरसेप्ट कर सकता है और उपयोगकर्ता अनुरोध को वेबसाइट के किसी भी पेज या दूसरी वेबसाइट पर रीडायरेक्ट कर सकता है।

यदि आपका web server logs, firewall या hosting control panel यह दिखाए कि संदिग्ध IP ranges केवल crawlers या bots को ही special response दे रहे हैं, तो यह संभावित cloaking का clear संकेत हो सकता है और तुरंत जांच की आवश्यकता होती है।

यूजर-एजेंट इंटरसेप्शन

- आपका ब्राउज़र यूजर एजेंट का एक उदाहरण है। स्पाइडर और क्रॉलर इसके अन्य उदाहरण हैं। मूल रूप से, यूजर एजेंट वे माध्यम हैं जो वेबसाइट से डेटा प्राप्त करते हैं। वेब सर्वर यूजर एजेंट की प्रकार पहचान कर सामग्री परोस सकते हैं।

कई malicious scripts user agents की list को regular update करते हैं, जिसमें Googlebot, Bingbot, social media crawlers और अन्य search engines शामिल होते हैं, ताकि वे इन specific agents के लिए अलग template, links या पूरी तरह दूसरा page serve कर सकें।

जावास्क्रिप्ट क्षमता

- उपयोगकर्ता ब्राउज़र आमतौर पर जावास्क्रिप्ट सक्षम होते हैं, जबकि सर्च इंजन क्रॉलर नहीं। इससे पता लगाना आसान हो जाता है कि JS सक्षम है या नहीं, और फिर सर्च इंजन बॉट्स को अलग पेज दिखाना।

यहां तक कि आधुनिक browsers और search engine crawlers अब काफी हद तक JavaScript execute कर सकते हैं, फिर भी कई attackers progressive enhancement और graceful degradation जैसे legitimate patterns की आड़ में users तथा bots के लिए अलग-अलग flows बना देते हैं, जो स्पष्ट रूप से नीति के खिलाफ है।

HTTP Accept-language हेडर परीक्षण

- यूजर अनुरोध का 'HTTP Accept-Language' एट्रिब्यूट सिस्टम को बताता है कि उपयोगकर्ता सर्च इंजन है। फिर क्लोकिंग लॉजिक अलग वेब पेज परोसता है।

Accept-Language, Location और अन्य headers का वैध उपयोग localisation, language selection और बेहतर user experience के लिए किया जा सकता है, लेकिन जब इन्हीं signals के आधार पर search bots को keyword-stuffed page और real visitors को सामान्य page दिखाया जाता है, तो यह स्पष्ट cloaking है।

HTTP_REFERER जांच

- इसी तरह, 'HTTP_REFERER' हेडर एट्रिब्यूट से पता चलता है कि उपयोगकर्ता एजेंट सर्च इंजन क्रॉलर है। इससे अलग-अलग वेब पेज संस्करण परोसना संभव होता है।

कुछ scripts referer header को check कर के यह तय करती हैं कि visitor search engine results page से आया है, social media से आया है या किसी अन्य website से; यदि केवल search results से आने वाले visitors को ही अलग page या popup दिखाया जाए, तो इसे भी deceptive practice के रूप में treat किया जा सकता है।

टेक्स्ट या लिंक छुपाना

- यह तकनीकी रूप से अन्य क्लोकिंग तकनीकों जैसा नहीं है, लेकिन यह सर्च इंजनों को धोखा देने का प्रयास है और इसे भी अवांछनीय माना जाता है।

- उदाहरण:

- छवि के पीछे टेक्स्ट छुपाना।

- फॉन्ट साइज को शून्य करना।

- टेक्स्ट का रंग बैकग्राउंड के समान करना (जैसे सफेद टेक्स्ट सफेद पृष्ठभूमि पर)।

- CSS या अन्य गैर-तकनीकी तरीकों से टेक्स्ट को स्क्रीन से हटाना।

ऐसी hidden text या hidden link based techniques अक्सर keyword stuffing, unnatural internal linking और manipulative anchor text patterns के साथ जुड़ी होती हैं, जो modern algorithms और manual reviewers के लिए पहचानना अपेक्षाकृत आसान हो चुका है।

कैसे जांचें कि आपकी वेबसाइट SEO क्लोकिंग का उपयोग कर रही है?

क्योंकि हैकर्स वेबसाइट में घुसपैठ कर क्लोकिंग कोड स्थापित कर सकते हैं, आपको समय-समय पर अपनी वेबसाइट की जांच करनी चाहिए। यह वेबसाइट मालिकों के लिए एक बेहतरीन अभ्यास है।

व्यवस्थित auditing process बनाने के लिए आप technical एसईओ checklist तैयार कर सकते हैं, जिसमें regular crawling, log file analysis, security scanning और manual page reviews जैसे steps शामिल हों, ताकि किसी भी unusual pattern को early stage पर पकड़ कर ठीक किया जा सके।

आप

Labrika की वेबसाइट उपलब्धता जांच

का उपयोग कर सकते हैं, जो तकनीकी साइट ऑडिट में मिलती है। यदि आपकी वेबसाइट में क्लोकिंग की समस्या हो तो इस ऑडिट में चेतावनी दिखाई देगी।

ऐसे automated tools आपके लिए first line of defence का काम करते हैं, लेकिन इनके साथ-साथ आपको Google Search Console के Coverage, Security issues, Manual actions और URL inspection reports को भी नियमित रूप से देखना चाहिए।

इसके अलावा, आप Google के URL इंस्पेक्शन टूल का उपयोग कर सकते हैं। यह आपको दिखाएगा कि Google आपके पेजों को कैसे देखता है, और आप पेज की सामग्री या कोड में आवश्यक सुधार कर सकते हैं। "website cloaking checker" खोजने पर कई मुफ्त टूल मिलेंगे जो तुरंत जांच कर सकते हैं। वैकल्पिक रूप से, पेशेवर वेबसाइट रखरखाव सेवाएं ये जांच सेवा पैकेक का हिस्सा के रूप में करती हैं, जिससे आपको शांति मिलती है। आप Google या Google Search Console से हैकिंग अलर्ट भी सेट कर सकते हैं।

- अपने browser से page को सामान्य रूप से open कर के content, links और design देखें, फिर वही URL Google Search Console के URL Inspection या अन्य crawling tool से fetch कर के compare करें कि दोनों versions में कोई अंतर तो नहीं है।

- server logs और analytics data (जैसे Google Analytics) का analysis करें, ताकि यह पता चल सके कि search engine bots को unusual redirects, 302 chains या अलग response codes तो नहीं मिल रहे।

- security plugins, malware scanners और independent website cloaking checker services का उपयोग कर के regular health reports generate करें और किसी भी suspicious findings पर तुरंत action लें।

SEO क्लोकिंग समस्याओं को कैसे ठीक करें

जब आपको पता चले कि आपकी वेबसाइट पर क्लोकिंग समस्या है, तो यह पेशेवर सहायता लेने का समय हो सकता है। इसे पहचानना और ठीक करना दोनों ही श्रमसाध्य और तकनीकी हो सकते हैं। इसे ठीक करने और भविष्य में समस्या न हो, यह सुनिश्चित करने के लिए विशेषज्ञ मदद जरूरी होती है। क्लोकिंग की समस्या को तुरंत ठीक करना चाहिए क्योंकि यह आपकी रैंकिंग और पैसे पर जल्दी प्रभाव डाल सकती है। आगे बढ़ते हुए क्लोकिंग जांचना आपकी वेबसाइट प्रबंधन की नियमित प्रक्रिया का हिस्सा होना चाहिए।

व्यावहारिक रूप से remediation process में malicious code हटाना, .htaccess या server configuration को साफ करना, database entries की सफाई, users और search engines दोनों के लिए consistent contents बहाल करना, फिर search engines को reconsideration request या re-crawl के माध्यम से updated स्थिति की information देना शामिल होता है।

अक्सर यह भी आवश्यक होता है कि आप अपनी overall एसईओ strategy, site structure, internal linking, keyword research, content and technical foundations को दोबारा evaluate करें, ताकि future में किसी भी तरह की vulnerability या shortcut temptation से बचा जा सके और long term sustainable एसईओ growth हासिल हो सके।

SEO क्लोकिंग से बचने के लिए सर्वोत्तम प्रथाएँ

किसी भी serious business website के लिए यह जरूरी है कि वह शुरू से ही clear policies और documented processes के साथ काम करे, ताकि developers, content creators और marketing teams सभी जानते हों कि कौन-सी practices allowed हैं और कौन-सी strictly prohibited हैं।

- हमेशा high quality, unique contents और informative article तैयार करें, जो users के questions का स्पष्ट उत्तर दें और search engines के लिए भी relevant signals प्रदान करें।

- site की technical health पर नियमित काम करें, जैसे page speed optimize करना, clean url structure रखना, mobile-friendly design अपनाना, robots और meta directives सही तरह से configure करना और crawl budget को व्यर्थ न जाने देना।

- white hat strategies अपनाएं, जिनमें natural link building, guest posting, social media share, local citations, online reviews और structured data markup जैसी actions शामिल हों, जो organic visibility, brand authority और overall quality score को बेहतर बनाती हैं।

- कोई भी aggressive ads, misleading redirects, doorway pages या hidden elements इस्तेमाल न करें, क्योंकि ये न केवल algorithms के खिलाफ हैं बल्कि users के trust और long term results के लिए भी हानिकारक हैं।

- अपनी टीम को नियमित रूप से प्रशिक्षित करें, ताकि वे search engine optimization, security best practices और latest algorithm updates के बारे में learn कर सकें और common hacking tactics, cloaking scripts या suspicious plugins को पहचान पाएं।

- website पर स्पष्ट contact details, forms और customer support information रखें, ताकि visitors आसानी से आपसे संपर्क कर सकें और किसी भी security या spam issue की रिपोर्ट तुरंत कर सकें।

Relevant SEO and analytics checklist (English)

For international teams working on search engine optimization, it is useful to maintain a concise checklist of concepts: what seo is, which types seo to use, where off page seo complements technical work, and how keyword research, high quality contents and user experience together help your site rank higher in the serp. You also need to understand why seo important for business growth, and how to interpret the intent behind queries where users simply type seo seo or phrases like seo and advertising in search engines. You can use tools like Google Search Console, analytics platforms and other free or paid resources to discover crawl errors, improve site speed, see which pages generate more organic traffic, and learn about users, their location, language and devices.

This guide also reminds you that digital marketing is not only about one web channel; social media platforms such as youtube, instagram and others can grow your business, bring new visitors and lead users back to your website. When you design your pages, pay attention to title, description, alt attributes, internal link building, external backlinks, url format, domain history and robots directives, because these factors are closely related to rankings and overall visibility. By using data driven analysis, creating content and services that match search intent, and optimizing both on-page and off-page strategies, you can increase conversions, generate more leads than any previous campaign and make your online strategy the best it can be.

Whether you work in-house or with an agency, always document your processes, from keyword selection to contents publishing, so that any change in structure, design or technical configuration can be traced back if something goes wrong. Regular log analysis, monitoring of backlinks, reviewing advertising and ads campaigns, checking contact forms, and ensuring that both marketing and computer security teams and non technical stakeholders share insights will help protect your brand. Also verify that your com domain or other domains are not being misused, and respond quickly to new threats or suspicious activity. All these actions, when combined with ethical seo and careful monitoring of websites across the internet, make it possible to avoid common cloaking practices and keep your sites safe for users and search engines alike.

सुविधा और शांति के लिए, यह कार्य आप Labrika के तकनीकी साइट ऑडिट > वेबसाइट उपलब्धता जांच के माध्यम से कर सकते हैं।

FAQ: SEO cloaking से जुड़े सामान्य प्रश्न

1. How does cloaking affect search engine optimization and rankings?

Cloaking सीधे तौर पर search engine optimization के core principles के खिलाफ है, क्योंकि यह search engines को गलत signals देता है और users के लिए अलग contents दिखाता है। जब algorithms या reviewers इस behavior को detect करते हैं, तो site को lower rankings, traffic loss, manual action या complete de-indexing जैसी penalties झेलनी पड़ सकती हैं। इसका असर केवल एक page पर नहीं, कई बार पूरे domain तथा related websites पर पड़ सकता है।

साथ ही, जब cloaked pages user experience को खराब करते हैं, तब bounce rate बढ़ता है, conversion घटता है और business goals प्रभावित होते हैं, जिससे overall digital performance और भी weak हो जाती है।

2. क्या हर dynamic content या personalisation cloaking माना जाता है?

नहीं। Dynamic content, A/B testing, personalisation, location-based recommendations या language selection तब तक सुरक्षित हैं जब तक search engines और users दोनों के लिए core information, main headings, title, description, primary keywords और overall structure broadly समान रहे।

उदाहरण के लिए आप:

- users की location के आधार पर currency, contact number या store location बदल सकते हैं,

- returning visitors के लिए previously viewed products दिखा सकते हैं,

- logged-in users के लिए personalised dashboard provide कर सकते हैं।

जब तक ये changes transparent हैं और केवल convenience व better user experience के लिए हैं, इन्हें cloaking नहीं माना जाता।

3. How can you use Google Search Console to detect issues?

Google Search Console कई practical reports और tools provide करता है जो cloaking व related problems detect करने में help कर सकते हैं:

- URL Inspection – यह दिखाता है कि Googlebot किसी specific URL को कैसे crawl और render कर रहा है; आप इसे own browser view के साथ compare कर सकते हैं।

- Coverage report – sudden drops, soft 404s, redirect issues या suspicious indexing patterns potential problems की ओर इशारा कर सकते हैं।

- Security issues और Manual actions – यदि hacked content, spam या cloaking detect होती है, तो यहाँ clear notifications और remediation guidance मिलती है।

इन reports को नियमित रूप से read करना और necessary actions तुरंत लेना किसी भी serious site owner या agency की responsibility होनी चाहिए।

4. Off page seo और cloaking का आपस में क्या संबंध है?

Off page seo मुख्यतः backlinks, brand mentions, social media signals और authority building से संबंधित होता है, जबकि cloaking on-page और server-side behavior का हिस्सा है। लेकिन कई spam campaigns दोनों को साथ use करते हैं: पहले cloaked pages बनते हैं, फिर उन्हें support करने के लिए low quality backlinks, guest posts और paid link schemes run किए जाते हैं।

यह combination short term में कुछ rankings ला सकता है, पर long term में domain की credibility नष्ट कर सकता है। Ethical off page seo में transparent link building, high quality guest content, genuine social share और user-focused outreach शामिल होना चाहिए, न कि cloaking या hidden redirects।

5. क्या free या paid seo tools खुद cloaking कर सकते हैं?

सामान्यतः reputed tools ऐसा नहीं करते, लेकिन कुछ shady plugins, themes या scripts आपकी जानकारी के बिना spammy redirects, hidden links या cloaking logic add कर सकते हैं। इसलिए:

- केवल trusted sources से ही plugins और themes use करें,

- code review या independent security scan के बिना unknown scripts install न करें,

- analytics और server logs में unusual traffic patterns पर नज़र रखें।

यदि कोई free tool suspicious behavior दिखाए, जैसे कि अचानक extra advertising scripts, popups या unknown external calls, तो उसे तुरंत हटाना और site का audit कराना बेहतर है।

Step-by-step audit checklist (English)

The following structured checklist helps you or your agency run a focused analysis of your site to discover any cloaking or similar issues. It is designed so that both technical and non technical team members can work together and use common terminology.

| Step | Action | Tools / Data | Main goal |

| 1 | Compare what users see with what search engines see for key pages, including home, top landing pages and important service pages. | Browser, Google Search Console URL Inspection, other crawl tools | Detect any difference in contents, links, title, description or design that could indicate cloaking. |

| 2 | Check server-side rules, redirects and rewrite conditions that may send different responses based on user agent, ip or referrer. | .htaccess, server config files, hosting panel | Identify hidden rules that only affect bots or specific locations. |

| 3 | Review installed plugins, themes and third party scripts on your site. | CMS admin panel, code repository, file manager | Find unknown or outdated components that might inject hidden links or cloaked content. |

| 4 | Analyze access logs for unusual patterns, like many requests from search engines receiving different http status codes or redirects. | Server logs, log analysis tools | Spot suspicious behavior that normal users do not experience. |

| 5 | Scan the site for hidden text, invisible links or keyword stuffing that is only visible to bots. | Crawling software, browser developer tools | Ensure there is no hidden content added by hackers or previous seo vendors. |

| 6 | Check backlinks and referring domains for hacked websites, spam networks or unusual anchors pointing to your pages. | Backlink analysis tools, Search Console links report | Find risky off site patterns that may accompany cloaking attacks. |

| 7 | Create a remediation plan, assign responsibilities and define a time frame for fixes. | Project management system, internal guides | Organize the work so that technical, content and security teams can act in sync. |

Business दृष्टिकोण से सारांश

जब website या पूरी online strategy पर विचार किया जाता है, तो cloaking को केवल technical समस्या के रूप में नहीं, बल्कि business risk के रूप में देखना चाहिए। यह risk कई स्तरों पर दिखाई देता है:

- Revenue impact – rankings गिरने से organic traffic घटता है, leads और sales कम होते हैं, और paid advertising पर dependency बढ़ती है, जिससे कुल acquisition cost higher हो सकती है।

- Brand trust – यदि users को misleading pages, spam या security warnings दिखते हैं, तो brand perception खराब होता है और competitors को फायदा मिलता है।

- Legal and compliance – कुछ markets में deceptive online practices पर regulatory scrutiny भी हो सकती है, जिससे additional cost और reputation damage हो सकता है।

इसलिए decision-makers के लिए यह समझना महत्वपूर्ण है कि short term gains के लिए risky tactics अपनाने से बेहतर है sustainable, white hat strategies में निवेश करना, जो वेबसाइट को long term में मजबूत foundation देती हैं।

Long term SEO strategy और cloaking से दूरी

एक मजबूत, data-driven strategy कई pillars पर आधारित होती है, जो मिलकर आपकी website की visibility और performance improve करती है:

- Technical foundation – fast loading pages, clean architecture, logical internal linking, clear robots directives, proper use of meta tags, alt attributes और structured data।

- Content excellence – user questions पर based research, clear structure, helpful information, unique insights और ऐसा format जो desktop, mobile और अन्य devices पर well read हो सके।

- User experience – simple navigation, intuitive design, easy contact options, language clarity, and minimal friction in the conversion process.

- Authority building – relevant backlinks, partnerships, guest publications, social media presence और consistent brand messaging।

- Measurement and improvement – analytics, a/b tests, heatmaps, log analysis और regular reporting के माध्यम से continuous optimization।

जब ये सभी factors aligned होते हैं, तो किसी भी तरह की cloaking, hidden redirects या manipulative tactics की आवश्यकता नहीं रहती; organic growth स्वाभाविक रूप से आती है और risk profile बहुत कम हो जाता है।

टीम, प्रक्रियाएँ और जिम्मेदारियाँ

किसी भी मध्यम या बड़े आकार की website के लिए स्पष्ट governance structure आवश्यक है, ताकि cloaking जैसी समस्याएँ केवल technical टीम पर निर्भर न रहें, बल्कि पूरे संगठन की shared responsibility बनें।

आंतरिक टीम संरचना

- SEO / digital lead – search engine optimization strategy, priorities और overall results के लिए जिम्मेदार व्यक्ति, जो business goals को technical और content activities के साथ align करता है।

- Technical owner – developers या engineers की टीम, जो server configuration, codebase, cms, security hardening, robots directives और site structure को manage करती है।

- Content और UX टीम – writers, editors, designers और ux specialists, जो content and user experience को business objectives के अनुसार shape करते हैं।

- Analytics और insights टीम – data collection, reporting, analysis और optimisation recommendations के लिए जिम्मेदार group।

इन सभी roles को यह समझना चाहिए कि cloaking या deceptive tactics short term metrics भले ही बढ़ा दें, पर long term में business value और user trust को नुकसान पहुँचाती हैं, इसलिए कोई भी initiative शुरू करने से पहले उसे एसईओ guidelines और security best practices के against verify किया जाए।

एजेंसी या external expert के साथ काम करते समय

यदि आप किसी agency या external expert के साथ work करते हैं, तो शुरुआत में ही साफ-साफ written agreement तैयार करना उपयोगी होता है, जिसमें यह mentioned हो कि:

- केवल white hat methods, transparent link building और ethical optimization techniques use की जाएँगी,

- कोई भी hidden text, cloaked redirects, private blog networks या paid link schemes project का हिस्सा नहीं होंगे,

- आपको regular reports मिलेंगी, जिनमें स्पष्ट रूप से बताया जाएगा कि कौन-सी actions ली गईं और उनके results क्या रहे,

- site के code, server rules, robots settings या design में किए गए हर significant change का documentation रखा जाएगा।

इस प्रकार आप न केवल बेहतर control रखते हैं, बल्कि किसी unexpected penalty या traffic drop की स्थिति में root cause जल्दी discover कर सकते हैं।

हैकिंग, cloaking और incident response

कई बार cloaking का कारण जानबूझकर किया गया deceptive marketing नहीं, बल्कि security breach होता है। ऐसे मामलों में तेज और structured response plan critical होता है।

Incident response के मुख्य चरण

- Identify – logs, crawl data, user reports या Search Console alerts के माध्यम से समस्या का पता लगाना।

- Contain – अस्थायी रूप से suspicious functionality disable करना, admin access सुरक्षित करना, passwords और keys बदलना।

- Eradicate – malicious code, unknown plugins या scripts हटाना, database और file system को clean करना।

- Recover – clean backup से आवश्यक files पुनर्स्थापित करना, core web vitals और usability की testing करना, फिर site को re-crawl के लिए तैयार करना।

- Review – घटना के बाद detailed analysis कर के यह समझना कि breach कैसे हुआ, और future में similar issues रोकने के लिए कौन-सी measures अपनाई जाएँ।

इस पूरे process के दौरान users को clear information देना, support channels open रखना और search engines को जिस हद तक आवश्यक हो उतना detail provide करना, trust और transparency बनाए रखने में मदद करता है।

International, multi-language और multi-domain websites के लिए विशेष ध्यान

जब business कई देशों, languages और domains पर operate करता है, तो cloaking की detection और prevention और भी जटिल हो जाती है।

- Hreflang और regional targeting – सही hreflang implementation, clear language and country codes, और अलग-अलग locations के लिए consistent contents रखने से search engines को समझने में आसानी होती है कि कौन-सा version किस user के लिए है, बिना cloaking के सहारे।

- Consistent policies across domains – यदि आपके पास multiple websites या subdomains हैं, तो सभी पर एक जैसी security, seo और content policies लागू करना जरूरी है, ताकि किसी एक कमजोर कड़ी के कारण बाकी network भी प्रभावित न हो।

- Centralized monitoring – unified analytics, log aggregation और security dashboards के माध्यम से आप पूरे ecosystem पर नज़र रख सकते हैं और किसी भी unusual pattern को जल्दी detect कर सकते हैं।

क्वालिटी, relevance और search intent

Cloaking अक्सर इस बात का संकेत होता है कि website पर वास्तविक high value contents की कमी है, और business users की जरूरतों के बजाय algorithms को प्रभावित करने पर अधिक ध्यान दे रहा है।

दूसरी ओर, जब आप search intent पर based research करते हैं – users क्या ढूंढ रहे हैं, कौन-से questions पूछ रहे हैं, वे किस प्रकार का format पसंद करते हैं – तो आप naturally ऐसी information तैयार करते हैं जो both users और search engines के लिए useful होती है, और किसी deceptive tactic की आवश्यकता समाप्त हो जाती है।

- informational queries के लिए गहराई से research आधारित guides, how-to articles और step-by-step explanations,

- commercial queries के लिए clear comparison, features, pricing और transparent benefits,

- transactional queries के लिए frictionless forms, secure checkout और स्पष्ट calls to action।

जब pages इस तरह से structured होते हैं, तो वे उच्च engagement, बेहतर dwell time और stronger organic performance दिखाते हैं, जो किसी भी artificial manipulation की तुलना में अधिक sustainable है।

KPIs और performance measurement

SEO और overall digital performance को track करने के लिए कुछ key metrics पर लगातार नज़र रखना जरूरी है, ताकि यदि cloaking या hacking जैसी कोई घटना हो, तो उसका impact जल्दी detect किया जा सके।

- Organic traffic – specific pages, countries, devices और languages के स्तर पर नियमित monitoring,

- Rankings – priority keywords और strategic topics के लिए serp positions,

- Conversions और leads – forms, calls, sign-ups या other goals के माध्यम से real business impact,

- Bounce rate और engagement – sudden बदलाव suspicion का संकेत हो सकते हैं, विशेष रूप से जब वे किसी single page या section तक सीमित हों,

- Index coverage और crawl stats – search engines आपकी site को किस frequency और depth तक crawl कर रहे हैं, कौन-सी errors या warnings हैं।

इन metrics को month-on-month और year-on-year compare करना, normal fluctuation और असामान्य गिरावट के बीच अंतर समझने में मदद करता है।

रिसोर्स प्लानिंग और लगातार सुधार

भले ही आप cloaking से पूरी तरह बचना चाहते हों, फिर भी बिना पर्याप्त resources, time और skilled people के यह objective practically achieve करना मुश्किल हो सकता है। इसलिए budget planning में निम्नलिखित components को शामिल करना समझदारी है:

- regular technical audits और security checks के लिए dedicated hours,

- training budget, ताकि team नए search engine guidelines, technical trends और common hacking tactics के बारे में updated रहे,

- reliable hosting, backup और monitoring solutions,

- content creation, updating और optimisation के लिए continuous investment।

यह long term दृष्टिकोण eventually यह सुनिश्चित करता है कि आपकी website केवल compliant ही नहीं, बल्कि competitive भी रहे।

कानूनी, नैतिक और ब्रांड-सुरक्षा परिप्रेक्ष्य

क्लोकिंग अक्सर केवल guideline violation नहीं, बल्कि broader compliance और brand-safety issue भी बन सकता है। यदि किसी regulated उद्योग – जैसे finance, healthcare या insurance – की website पर cloaked content के जरिये misleading claims, अप्रूव न की गई offers या गलत legal disclosures दिखाए जाएँ, तो regulators की नज़र में यह serious breach माना जा सकता है।

इसी तरह, यदि hacked cloaked pages users को malware, illegal सामग्री या phishing forms की ओर भेजते हैं, तो brand की दीर्घकालिक reputation risk में आ जाती है, भले ही business ने यह activity स्वयं न की हो। इसलिए contracts, internal policies और vendor agreements में साफ उल्लेख होना चाहिए कि किसी भी तरह की cloaking या deceptive search practice स्वीकार्य नहीं है, और पाए जाने पर तुरंत remediation व reporting की प्रक्रिया follow की जाएगी।

एसईओ एजेंसी या consultant चुनने के लिए व्यावहारिक चेकलिस्ट

कई बार cloaking या अन्य spammy tactics इसलिए implement हो जाते हैं क्योंकि external vendor जल्दी परिणाम दिखाने के दबाव में गलत shortcuts अपनाता है। नीचे दी गई संक्षिप्त checklist किसी भी एसईओ partner का मूल्यांकन करने में मदद कर सकती है:

- क्या वे clear strategy document और timeline provide करते हैं, जिसमें technical, content और off page activities अलग-अलग defined हों?

- क्या वे openly बताते हैं कि केवल white hat methods और search engine guidelines compliant approaches का ही उपयोग करेंगे?

- क्या वे आपको उन sites या case studies के examples दिखाते हैं जहाँ long term organic growth, better user experience और business results पर फोकस किया गया हो, न कि केवल short term rank jumps पर?

- क्या reporting में वे केवल rankings नहीं, बल्कि traffic quality, conversions, lead volume और revenue-impact जैसे metrics भी शामिल करते हैं?

- क्या contract में साफ लिखा है कि cloaking, hidden redirects, doorway pages, automated spam या किसी भी प्रकार की deceptive advertising strictly prohibited है?

- क्या वे आपकी existing website का initial audit कर के स्पष्ट रूप से बताते हैं कि किसी past एसईओ काम से जुड़ी suspicious tactics पहले से मौजूद तो नहीं हैं?

ऐसे structured evaluation से आप केवल low cost या aggressive promises के आधार पर निर्णय लेने से बच सकते हैं और ऐसे partners चुन सकते हैं जो sustainable performance, high quality content और secure infrastructure पर जोर देते हों।

Cloaking, doorway pages और अन्य spam patterns का अंतर

कई बार cloaking दूसरे spam techniques के साथ mix हो जाती है, जिससे root cause समझना कठिन हो जाता है। कुछ प्रमुख patterns को अलग-अलग समझना उपयोगी होगा:

- Cloaking – search engines और users को एक ही URL पर अलग-अलग contents या structure दिखाना। यह user agent, ip, referrer या अन्य signals के आधार पर हो सकता है।

- Doorway pages – ऐसे multiple low-value pages जो similar keywords के लिए बनाए जाते हैं, users को सीधे किसी एक ही destination पर भेजते हैं और खुद कोई real value provide नहीं करते।

- Scraped / spun content – अन्य sites से copied या automated तरीके से बदली गई सामग्री, जो unique दिखने की कोशिश करती है पर वास्तव में low quality और often irrelevant होती है।

- Negative seo attacks – जब कोई third party spam backlinks, hacked links या malicious redirects का उपयोग करके आपके domain की credibility को नुकसान पहुँचाने की कोशिश करे।

हालाँकि ये सभी patterns अलग हैं, लेकिन इनके common effects समान हैं: rankings में instability, manual actions का risk, organic traffic में गिरावट और user trust में कमी। मजबूती से structured technical, content और security practices अपनाकर आप इन सभी threats के विरुद्ध defence create कर सकते हैं।

प्रैक्टिकल guidelines: developers, marketers और editors के लिए

डेवलपमेंट, marketing और editorial टीमें अक्सर अलग priorities के साथ काम करती हैं; पर cloaking और spam से बचने के लिए कुछ shared नियम सभी पर लागू होने चाहिए:

- कोई भी code change – विशेष रूप से redirects, user agent detection, geo-targeting या A/B testing से जुड़ा – documented और peer-reviewed होना चाहिए।

- marketers को new campaigns, tracking parameters, remarketing scripts या third party tags implement करते समय technical टीम से validation लेना चाहिए, ताकि accidentally कोई cloaking-like behavior न बन जाए।

- editors को keyword usage, headlines और meta description लिखते समय natural language, clarity और user intent का सम्मान करना चाहिए, न कि केवल search engines के लिए over-optimised या misleading text बनाना चाहिए।

- सभी teams को कम-से-कम basic level पर search engines कैसे crawl, index और rank करते हैं, इस बारे में training दी जानी चाहिए, ताकि वे समझ सकें कि किन actions से अनजाने में भी problems पैदा हो सकती हैं।

Monitoring framework: what to review and how often

एक मजबूत monitoring framework यह सुनिश्चित करता है कि यदि कभी cloaking या अन्य suspicious behavior site पर आ भी जाए, तो उसे जल्दी detect कर के neutralise किया जा सके।

- Weekly – key pages के organic traffic, conversions और मुख्य keywords की serp positions की high-level review, basic security alerts चेक करना।

- Monthly – Search Console coverage, crawl stats, security issues, manual actions और links reports की detailed समीक्षा; site speed और core technical metrics का assessment।

- Quarterly – comprehensive technical audit, including log analysis, plugin/theme review, internal link structure, robots directives और structured data validation।

- Annually – full strategic review: एसईओ roadmap, content performance, off page profile, competitor analysis और resource allocation की पुनः जाँच।

यह cadence organisation के आकार और site complexity के अनुसार adjust की जा सकती है, पर महत्वपूर्ण यह है कि monitoring ad-hoc न रहे, बल्कि well-defined process के रूप में operate करे।

संक्षिप्त निष्कर्ष: सुरक्षित और टिकाऊ एसईओ की दिशा में

Cloaking, चाहे जानबूझकर implement की जाए या hacking के माध्यम से, किसी भी website के लिए दीर्घकालिक risk है। यह search engines के साथ संबंध खराब करती है, users का trust घटाती है और business performance को unpredictable बनाती है। इसके विपरीत, साफ-सुथरा technical setup, transparent communication, high quality content और ethically-driven एसईओ approach मिलकर ऐसा foundation बनाते हैं जिस पर आप स्थिर growth, बेहतर conversions और मजबूत brand authority विकसित कर सकते हैं।

यदि आपकी team के पास in-house technical expertise नहीं है, तो भी आप structured checklists, clear vendor contracts, reliable auditing tools और regular education initiatives के माध्यम से risk को काफी हद तक control कर सकते हैं। महत्वपूर्ण यह है कि आप किसी भी short-term benefit के लिए long-term health को compromise न करें, और हर optimisation decision लेते समय यह सवाल पूछें कि क्या यह users और search engines दोनों के लिए genuinely बेहतर अनुभव बना रहा है या नहीं।

इसी दिशा में, technical audits, availability checks और security-focused reviews जैसे tools आपकी day-to-day operations का स्वाभाविक हिस्सा बनने चाहिए। जब monitoring, prevention और remediation – तीनों pillars मजबूत होते हैं, तो cloaking जैसी समस्याएँ isolated incidents तक सीमित रहती हैं और entire digital strategy, including एसईओ, content, social media और broader marketing, लंबे समय तक स्थिर रूप से grow कर पाती है।

31 दिसंबर 2025 को अद्यतन किया गया